Zespół z University of Cambridge opracował dwa rozwiązania, które mają pozwolić na opracowanie autonomicznych samochodów bez użycia drogich komponentów, takich jak radary czy lidary. Anglicy uznali, że skoro człowiekowi wystarczy do prowadzenia samochodu wzrok i umysł, to autonomiczny pojazd również powinien się zadowolić prostą kamerą i jednostką obliczeniową, czyli właściwie tym, co można znaleźć dzisiaj w każdym smartfonie.

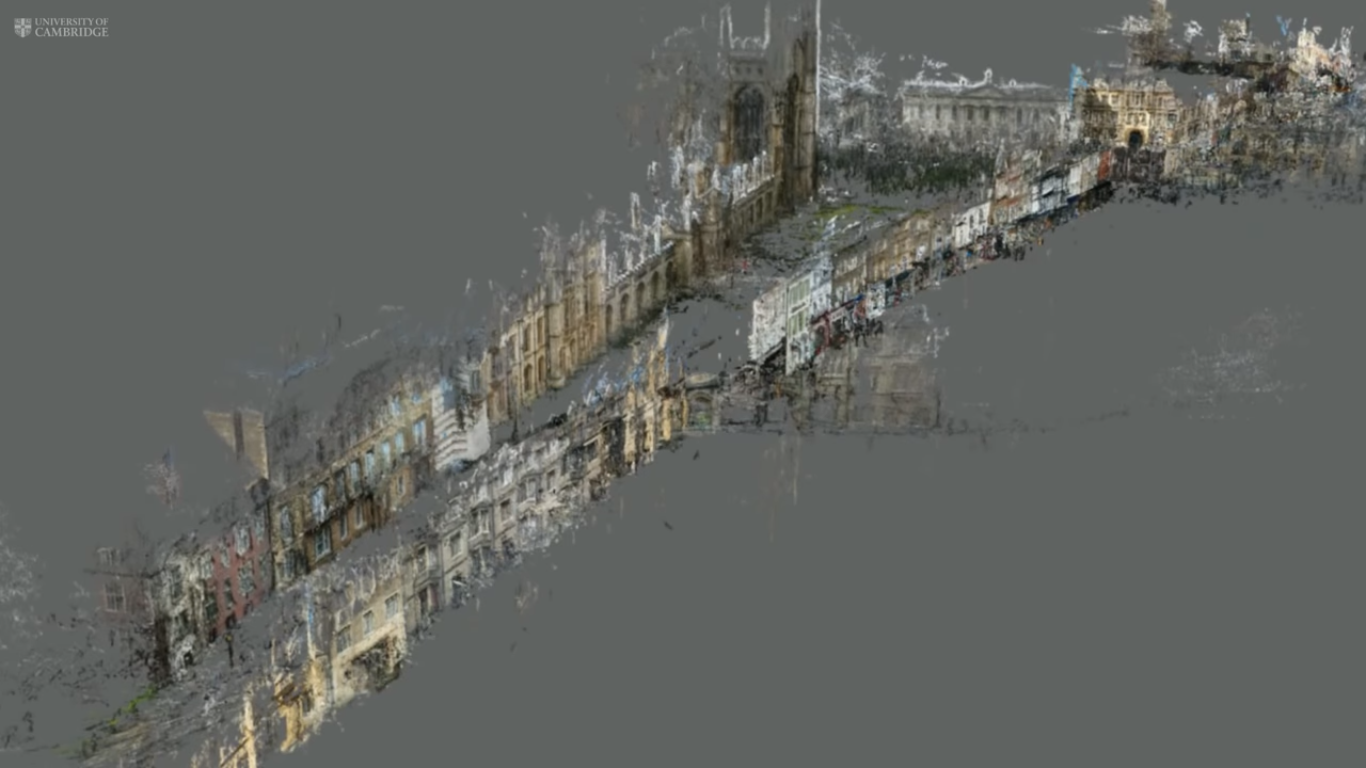

Oba systemy zostały zbudowane na bazie popularnych ostatnio algorytmów uczenia maszynowego. Mają odpowiadać na pytania „gdzie jestem?” i „co mnie otacza”? Pierwszy z nich działa w oparciu o wygenerowaną zawczasu mapę 3D otoczenia i na podstawie kątów pod którymi widzi poszczególne obiekty określa swoje położenie z dokładnością większą niż ta osiągana przez cywilne odbiorniki GPS. Algorytm przetestowano przy tym na niewielkim, 1000-metrowej długości, fragmencie ulicy King’s Parade w Cambridge. Rozwiązanie na pewno okazałoby się znacznie ciekawsze, gdyby jego autorzy opracowali narzędzie pozwalające na konwersję obrazów z Google Street View na użyteczną mapę. Na szczęście marzenia nic nie kosztują.

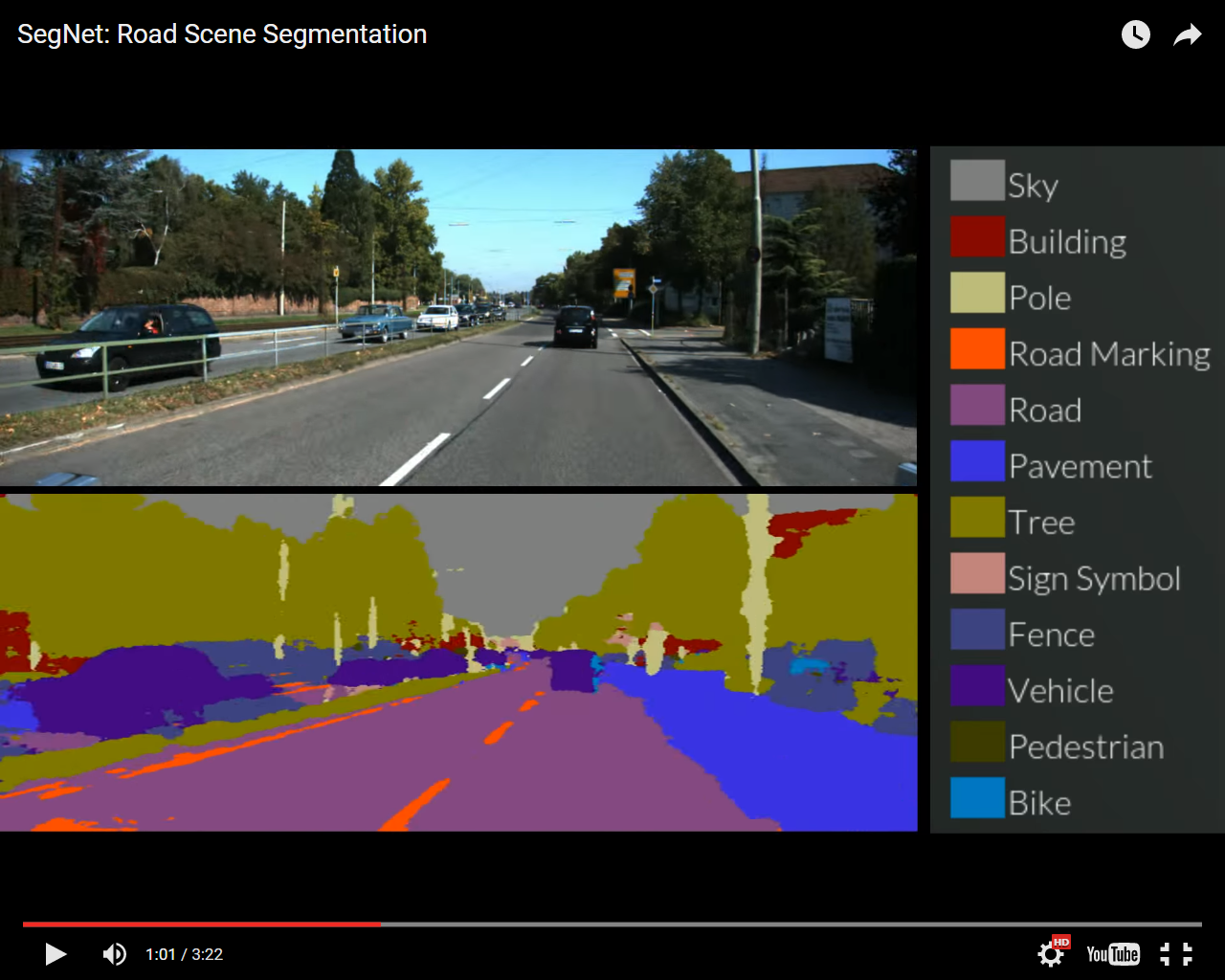

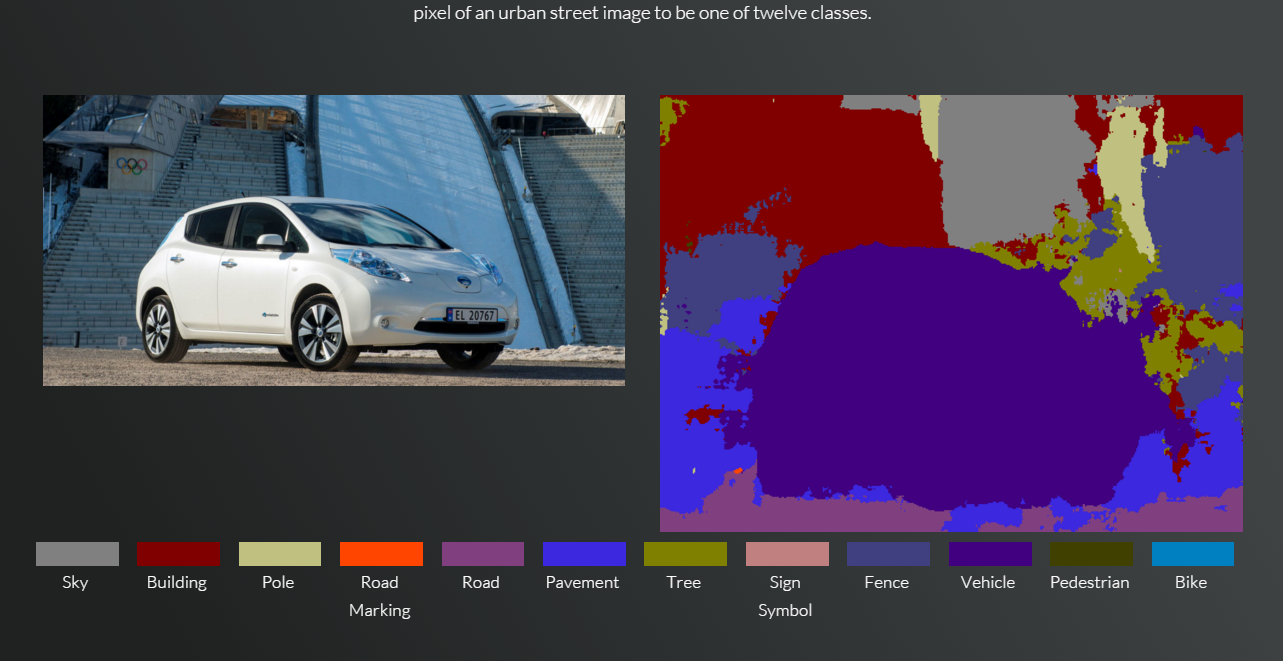

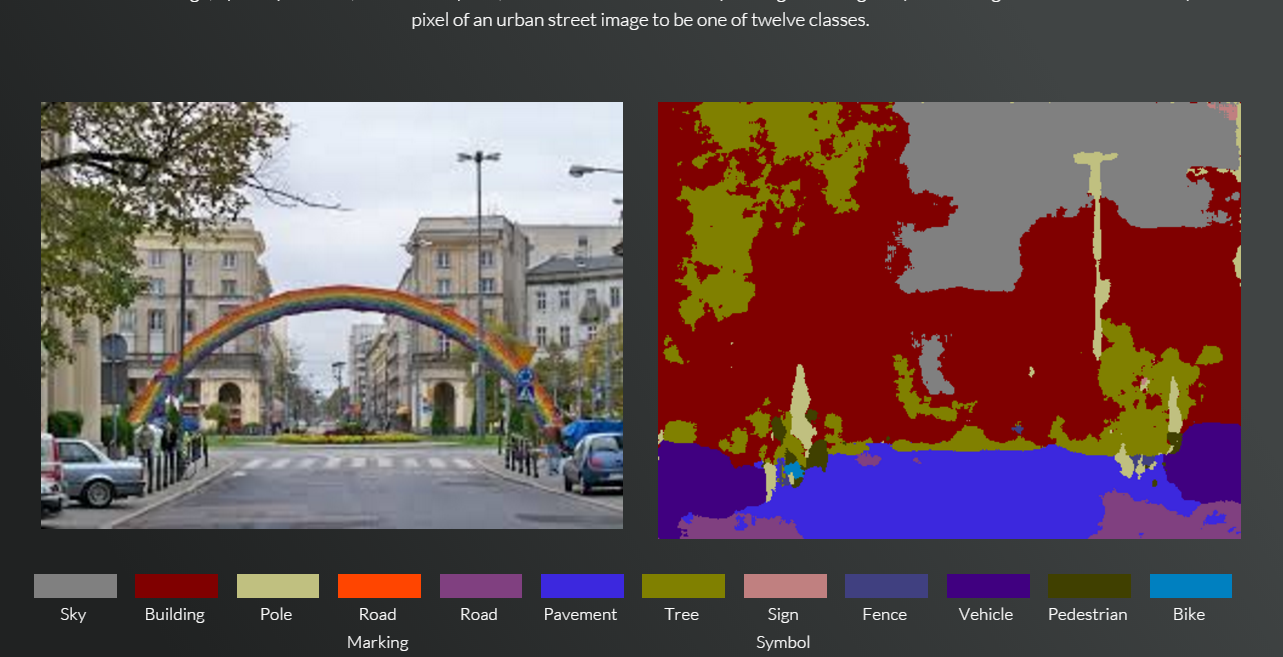

Drugi system interpretuje elementy otoczenia, mówi komputerowi co widzi. Algorytm rozpoznaje przynależność obserwowanych obiektów do 12 różnych klas, takich jak m.in. drzewa, samochody, przechodnie, znaki drogowe, droga, itd. Co ciekawe, program nauczył się rozpoznawać obrazy oglądając zdjęcia oryginalne wraz z ręcznie „pokolorowanymi” przez studentów wersjami. Biorący udział w projekcie ochotnicy oznaczyli – piksel po pikselu – poszczególne elementy na 5 tysiącach zdjęć, co w sumie zajęło im około 2500 roboczogodzin.

Program, nazwany SegNet, interpretuje obrazy, według autorów, z około 90% dokładnością. Choć pierwsza myśl, jaka mi przyszła do głowy, brzmi „ciągle o ponad 9% za mało”, zespół z Cambridge twierdzi, że to wynik lepszy niż uzyskiwany przez inne systemy rozpoznawania obrazu. System najlepiej radzi sobie z rozpoznawaniem elementów charakterystycznych dla dużych miast i autostrad – ponieważ na takich był szkolony. Nieco gorzej podobno mu idzie z krajobrazami wiejskimi, pustynnymi i zaśnieżonymi, choć można podejrzewać, że to tylko kwestia kolejnych 2500 godzin pracy studentów.

Działanie programu można przetestować samodzielnie, ponieważ twórcy udostępnili jego demo w internecie.

[źródło i grafika: gizmodo.com]