Kiedy to tylko możliwe, ludzie używają wszystkich swoich zmysłów, aby pojąć otoczenie, co przychodzi im (nam) bez większego zastanowienia. Jednak czymś takim nie mogą się pochwalić nadal roboty i to dlatego naukowcy z Laboratorium Informatyki i Sztucznej Inteligencji MIT (CSAIL) pracowali nad poprawieniem tego, co nazywają „robotyczną luką sensoryczną”.

Czytaj też: Sztuczna inteligencja generuje twarze na podstawie głosu

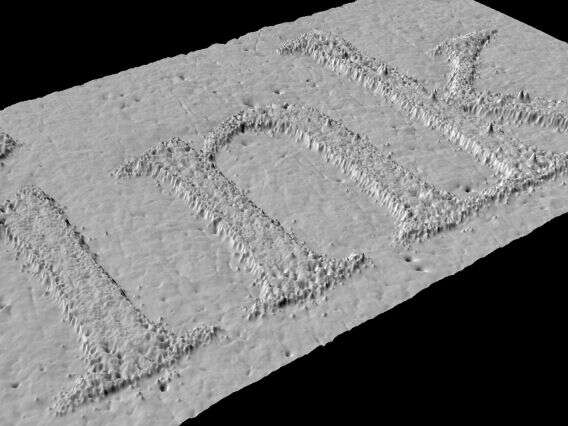

Aby połączyć wzrok i dotyk, inżynierowie CSAIL pracowali z ramieniem robota KUKA, typem często używanym w magazynach przemysłowych. Naukowcy wyposażyli go w specjalny czujnik dotykowy o nazwie GelSight – płytę z przezroczystego, syntetycznego kauczuku, który działa jako system obrazowania. W niego wciska się różne obiekty, które są nieustannie monitorowane przez szereg kamer.

Zespół CSAIL zarejestrował prawie 200 obiektów, w tym narzędzia, artykuły gospodarstwa domowego i tkaniny dotykane przez ramię robota ponad 12000 razy. Stworzyło to mnóstwo klipów wideo, które zespół mógł podzielić na 3 miliony statycznych obrazów, tworząc zbiór danych, który nazwali „VisGel”. Te połączył z tzw. Generatywnymi sieciami kontradyktoryjnymi (GAN). Jest to sieć neuronowa, składająca się tak naprawdę z dwóch z potencjałem do naśladowania obrazów, muzyki, mowy i prozy. Często kojarzyła się z artystycznym wykorzystaniem sztucznej inteligencji.

GAN współpracują z dwoma sieciami neuronowymi konkurującymi ze sobą. Jedna sieć jest uważana za „generator”, podczas gdy druga jest nazywana „dyskryminatorem”. Generator tworzy możliwie najbardziej realistyczne obrazy, a dyskryminator próbuje udowodnić, że te są tworzone. Za każdym razem, gdy dyskryminator wygrywa bitwę, generator jest zmuszony do zbadania własnej wewnętrznej logiki, tworząc i w teorii udoskonalając swój system. Naukowcy starali się następnie, żeby ten wygenerował buta wyłącznie na podstawie danych dotykowych.

Czytaj też: Sztuczna inteligencja wytwarza więcej CO2 niż samochody

Źródło: Popular Mechanics