Jeśli nawet jesteście zatwardziałymi zwolennikami produktów AMD, to nigdy nie możecie zapominać, że to Nvidia przyczynia się w ogromnym stopniu do rozwoju jednego z filarów naszej przyszłości – sztucznej inteligencji. Już teraz oferuje świetne rozwiązania, ale ostatnio poszła o krok dalej, odpowiadając sobie na pytanie, „Czy można zbudować coś skalowalnego… przy jednoczesnym zachowaniu konkurencyjnej wydajności na wat w całym spektrum?”

Czytaj też: Naukowcy chcą sprawdzić, jak SI poradzi sobie z testami dla zwierząt

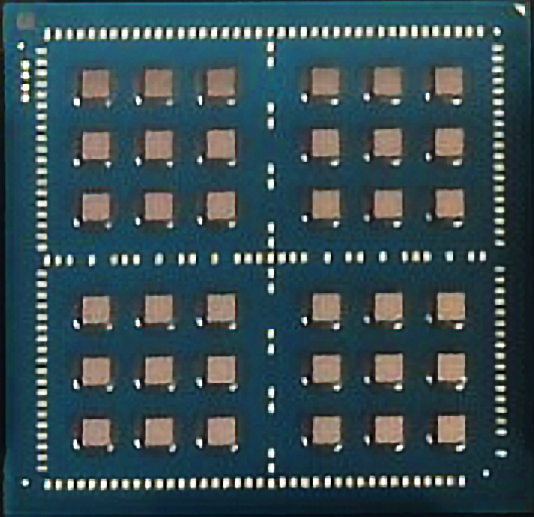

Jak się spodziewacie, odpowiedź brzmi „tak”. W zeszłym miesiącu w VLSI Symposia w Kioto, Nvidia ujawniła swój nowy niewielki chip testowy, który może pracować samodzielnie, aby wykonywać niskobudżetowe zadania lub zostać ściśle powiązany z maksymalnie 35 innymi układami z tej samej rodziny w jednym module, aby wykonywać obliczenia, o których nam się nawet nie śniło. Innymi słowy, Nvidia stworzyła niewielki układ, który dorównuje wydajności tym, które zajmują często ogrom miejsca w centrach danych.

Indywidualny układ akceleratora jest zaprojektowany tak, aby wykonywać głównie zadania głębokiego uczenia, a nie część treningową. Inżynierowie zazwyczaj mierzą wydajność „wnioskowania” takich chipów pod względem liczby operacji, które mogą wykonać na dżul energii lub milimetr powierzchni. Jeden z prototypowych chipów Nvidii osiąga szczyt 4,01 tera-operacji na sekundę (1000 miliardów operacji na sekundę) i 1,29 TOPS na milimetr. W porównaniu do wcześniejszych prototypów z innych grup, wykorzystujących obliczenia o tej samej precyzji, pojedynczy układ scalony był co najmniej 16 razy wydajniejszy pod względem powierzchni i 1,7 razy bardziej wydajny energetycznie. Połączony w 36-chipowy system osiągnął 127,8 TOPS. To 32-krotny wzrost wydajności, którego część pochodzi jednak z braku konieczności obsługi precyzyjnych obliczeń matematycznych, pewnych problemów z pamięcią DRAM i innych form sztucznej inteligencji poza splotowymi sieciami neuronowymi.

Obecnie firmy często dostosowują swoje technologie, żeby działać najlepiej w swoich niszach i przykładem na to może być startup Synitant. Ten wykorzystuje przetwarzanie analogowe w pamięci flash, aby zwiększyć wydajność w aplikacjach o niskim poborze mocy i niskim zapotrzebowaniu. Google z kolei przerobiło swoje układy Tensora tak, aby odpowiadały wyłącznie wysokowydajnym środowiskom w centrach danych.

Rewolucyjność Nvidii

Nvidia dlatego też rozpoczęła swoje najnowsze badania. Stara się nimi wykazać, że jedna technologia/jedno rozwiązanie może dobrze działać we wszystkich tych sytuacjach. Albo przynajmniej może wtedy, kiedy dane układy scalone są połączone z siecią siatkową Nvidii w module multichip. Moduły te są zasadniczo małymi obwodami drukowanymi lub taśmami krzemowymi, które utrzymują wiele układów scalonych w taki sposób, że można je traktować jako jeden duży układ scalony.

Te stają się coraz bardziej popularne, ponieważ pozwalają producentom postawienie na znacznie prostsze w produkcji chipy (zwane chipletami), a nie wielkie i znacznie droższe układy w formie wielkiego monolitu. To sprawia, że rozwiązanie jest tańsze i nie odbiega wydajnością od tych tradycyjnych. Ponadto na jednym takim module mogą znaleźć się układy do różnych zadań.

Wieloukładowe moduły w wydaniu Nvidii

Kluczem wieloukładowych (multichip) rozwiązań Nvidii do łączenia nowych chipów głębokiego uczenia się jest sieć interchip, która wykorzystuje autorską technologię nazywaną Ground-Referenced Signaling (GRS). Ta wykorzystuje różnicę między sygnałem napięciowym na przewodzie, a wspólną płaszczyzną do przesyłania danych, unikając wielu znanych pułapek tego podejścia.

Może przesyłać dane z szybkością 25 Gb/s za pomocą pojedynczego przewodu, podczas gdy większość technologii potrzebuje pary przewodów, aby osiągnąć tę prędkość. Używanie pojedynczych przewodów zwiększa oczywiście ilość danych, które można przesyłać z każdego milimetra krawędzi chipa. Co więcej, rozwiązanie GRS (jego opracowanie znajdziecie tutaj) jest bardzo energooszczędne.

A co Nvidia na tak wielkie dzieło? „Zrobimy lepsze”, bo już inżynierowie firmy pracują nad technologią, która podwaja wydajność obliczeniową tego rodzaju chipów aż dwukrotnie.

Czytaj też: Naukowcy stworzyli robota z gałęzi, który sam nauczył się chodzić

Źródło: Spectrum, Nvidia Research