To nie pierwszy raz, kiedy sztuczna inteligencja łoi tyłki profesjonalistom w StarCraft II (pozdrawiamy też OpenAI wspierane przez Elona Muska), ale tym razem to system DeepMind od Google pokazało w pełnej krasie, na co go stać.

Najnowsze zmagania DeepMind zakończyły się demonstracją sił w StarCraft II, w której to agent AlphaStar skutecznie pokonał zawodowych graczy, wygrywając dziesięć rund. Stanął naprzeciw dwóm zawodowym graczom z misją wygrania pięciu rund, co zrobił w obu przypadkach. Jednak to nie pierwszy raz, kiedy twór Google zaskakuje, ponieważ już w 2017 roku pokonał mistrza w grę Go, wchodząc jednocześnie w temat Starcrafta 2.

Dlaczego akurat tej gry Blizzarda? To całkiem proste, ponieważ studio postarało się o specjalne środowisko SC2LE dla naukowców i programistów. Z kolei Google wybrało Starcraft 2, ponieważ ta gra jest „wielkim wyzwaniem” dla agentów SI, stawiając przed nimi wiele zadań, które ci muszą wykonywać w czasie rzeczywistym. Umiejętności potrzebne do wygrania obejmują przygotowanie teoretyczne, operowanie na zmiennych sytuacjach, długoterminowe planowanie, grę w czasie rzeczywistym i spore pole do manewru. W blogu poświęconym DeepMind czytamy, że:

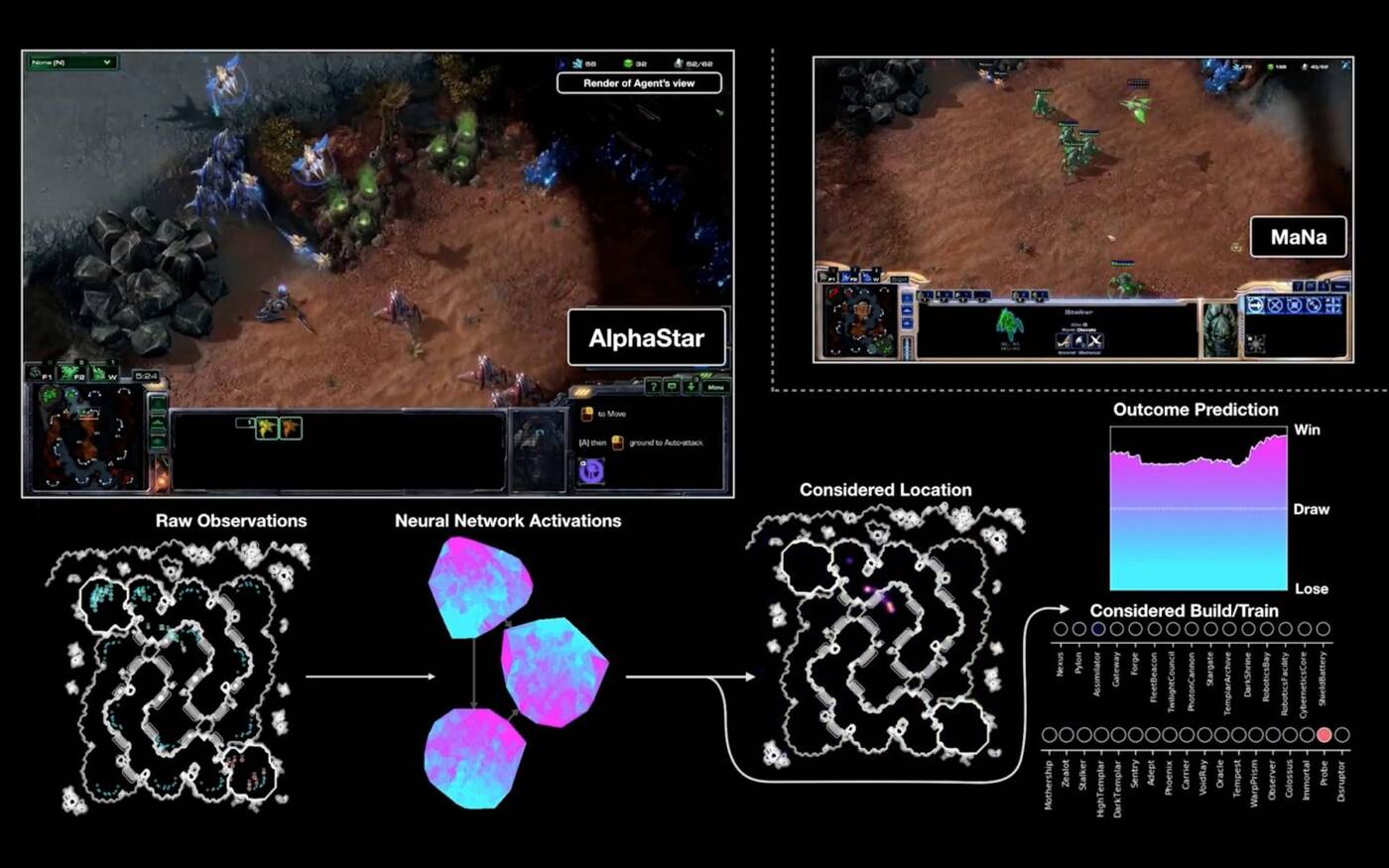

Zachowanie AlphaStar jest generowane przez głęboką sieć neuronową, która odbiera dane wejściowe z interfejsu surowej gry (listę jednostek i ich właściwości) i wyprowadza sekwencję instrukcji co do działania w grze. AlphaStar wykorzystuje również nowy algorytm uczenia się wielu agentów. Sieć neuronowa została początkowo przeszkolona przez nadzorowane uczenie się z anonimowych ludzkich gier. Dzięki temu AlphaStar nauczył się grać, naśladując podstawowe strategie używane przez profesjonalnych graczy StarCrafta.

Czytaj też: Pierwszy niekoreański mistrz StarCraft 2!

Źródło: Wccftech